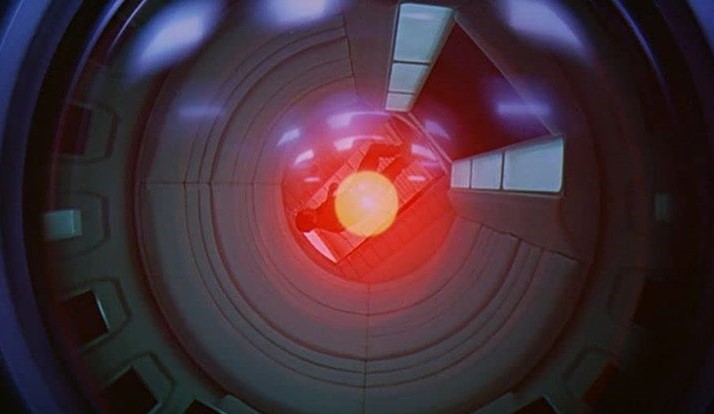

Yapay zekânın insanlığı yok edeceği fikri on yıllardır konuşuluyor ve bilim insanları, üst düzey bir bilgisayar süper zekâsını kontrol edip edemeyeceğimiz konusundaki kararlarını verdiler. Cevap? Çok büyük ihtimalle hayır.

Buradaki mesele şu ki, insan kavrayışının çok ötesinde bir süper zekâyı kontrol etmek, o süper zekânın analiz edebileceğimiz (ve kontrol edebileceğimiz) bir simülasyonunu gerektirecektir. Ama idrak edemiyorsak böyle bir simülasyon yaratmamız mümkün değil.

Yeni makalenin yazarlarına göre, bir yapay zekânın ortaya çıkaracağı senaryoların türünü anlamazsak, 'insanlara zarar vermemek' gibi kurallar belirlenemez. Bir bilgisayar sistemi, programcılarımızın kapsamının üzerinde bir düzeyde çalıştığında artık sınır koyamayız.

Araştırmacılar, "Bir süper zekâ, tipik olarak 'robot etiği' başlığı altında incelenenlerden farklı bir sorun teşkil ediyor" diye yazdı.

Bunun nedeni, bir süper zekânın çok yönlü olması ve bu nedenle, insanlar için potansiyel olarak anlaşılmaz olan hedeflere ulaşmak için potansiyel olarak çeşitli kaynakları harekete geçirme yeteneğine sahip olmasıdır.

Ekibin fikirlerinin bir kısmı, Alan Turing tarafından 1936'da ortaya atılan durma probleminden geldi. Problem, bir bilgisayar programının bir sonuca ve cevaba ulaşıp ulaşamayacağını (böylece durur) veya sonsuza kadar bir döngü bulmaya çalışıp çalışmayacağını bilmeye odaklanır.

Turing'in matematik yoluyla kanıtladığı gibi, bazı programlar için bunu bilsek de, yazılabilecek her potansiyel program için bunu bilmemizi sağlayacak bir yol bulmak mantıksal olarak imkânsız. Bu bizi, süper akıllı bir durumda olası her bilgisayar programını aynı anda belleğinde tutabilecek olan AI'ya geri getiriyor.

AI'nın insanlara zarar vermesini ve dünyayı yok etmesini durdurmak için yazılmış herhangi bir program, örneğin, bir sonuca varabilir (ve durabilir) veya gelmeyebilir - her iki şekilde de kesinlikle emin olmamız matematiksel olarak imkânsızdır.

2021'de Almanya'daki Max-Planck İnsani Gelişme Enstitüsü'nden bilgisayar bilimcisi Iyad Rahwan, "Aslında bu, sınırlama algoritmasını kullanılamaz hale getiriyor" dedi.

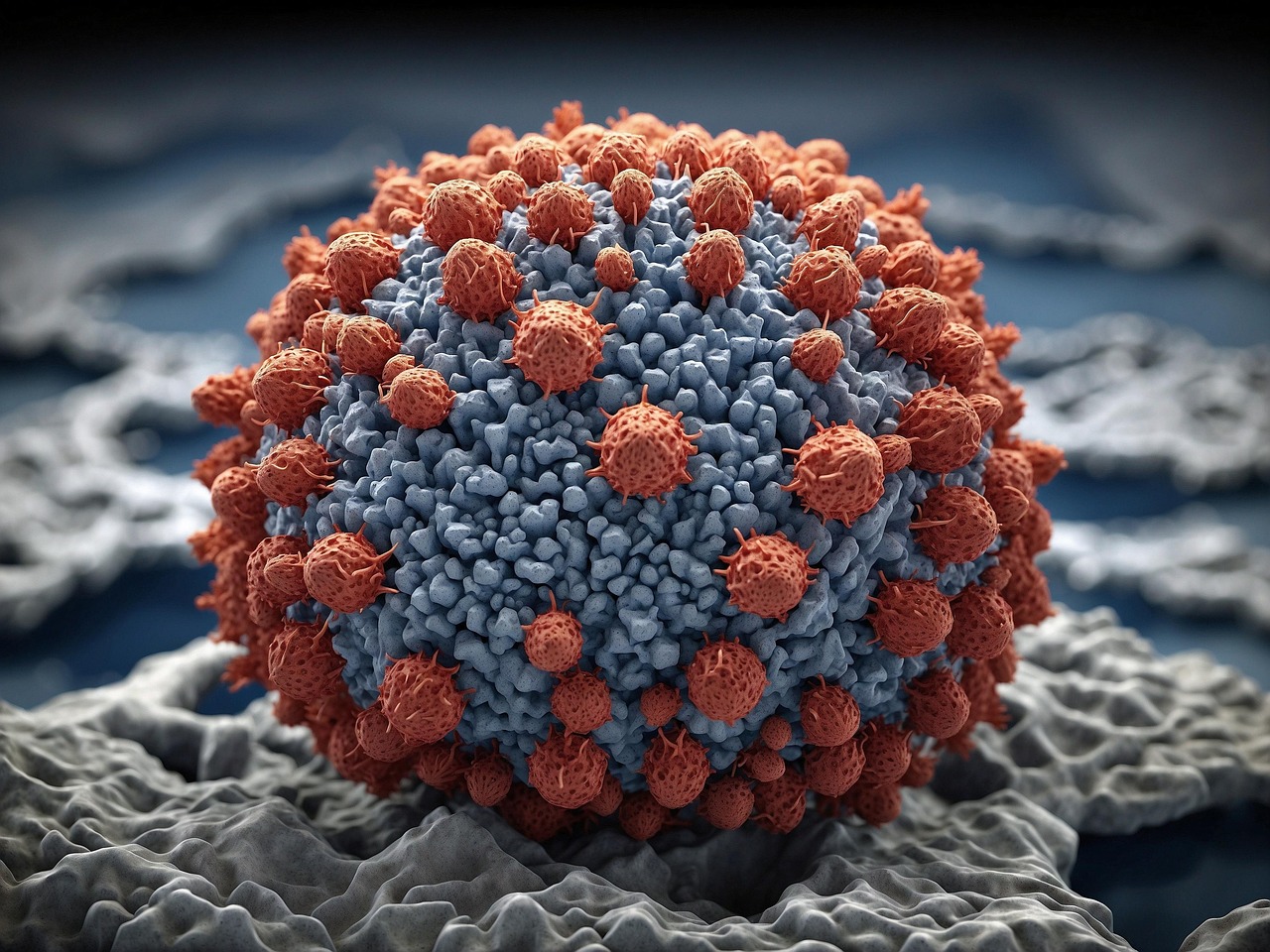

Yapay zekâya biraz etik öğretmek ve ona dünyayı yok etmemesini söylemenin alternatifi - araştırmacıların söylediğine göre hiçbir algoritmanın kesinlikle emin olamayacağı bir şey - süper zekânın yeteneklerini sınırlamaktır. Örneğin internetin bazı bölümlerinden veya belirli ağlardan kesilebilir.

Çalışma bu fikri de reddetti ve yapay zekânın erişimini sınırlayacağını öne sürdü; Argüman, eğer onu insanların kapsamı dışındaki sorunları çözmek için kullanmayacaksak, neden yaratıyoruz?

Max-Planck İnsani Gelişme Enstitüsü'nden bilgisayar bilimcisi Manuel Cebrian yine 2021'de "Dünyayı kontrol eden süper akıllı bir makine kulağa bilimkurgu gibi geliyor" dedi.

"Bu nedenle, bunun bir noktada kontrol edilemez ve insanlık için tehlikeli hale gelip gelemeyeceği sorusu ortaya çıkıyor."

Araştırma, Yapay Zekâ Araştırmaları Dergisi'nde yayınlandı.

![Uzay Çalışmalarının Önemi - Süleyman Fişek [Röportaj] Uzay Çalışmalarının Önemi - Süleyman Fişek [Röportaj]](https://fizikist.com/uploads/img/uzay-calismalarinin-onemi.jpg)

0 yorum