Ancak daha da temkinli olmak için nedenlerimiz olabilir. Yeni bir araştırmaya göre birçok yapay zekâ sistemi, insan kullanıcılara kasıtlı olarak yanlış bilgi sunma becerisini çoktan geliştirmiş durumda. Bu sinsi botlar aldatma sanatında ustalaşmış durumda.

Massachusetts Teknoloji Enstitüsü'nden (MIT) matematikçi ve bilişsel bilimci Peter Park, “YZ geliştiricileri, aldatma gibi istenmeyen YZ davranışlarına neyin neden olduğunu tam olarak anlamış değiller” diyor.

“Ancak genel olarak konuşursak, YZ aldatmacasının, aldatmaya dayalı bir stratejinin, söz konusu YZ'nin eğitim görevinde iyi performans göstermenin en iyi yolu olduğu ortaya çıktığı için ortaya çıktığını düşünüyoruz. Aldatma, hedeflerine ulaşmalarına yardımcı oluyor.”

YZ sistemlerinin kirli yalanlar konusunda özellikle becerikli olduklarını kanıtladıkları bir alan da oyunlardır. Araştırmacıların çalışmalarında dikkate değer üç örnek var. Bunlardan biri Meta'nın CICERO'su, oyuncuların müzakere yoluyla dünya hakimiyeti kurmaya çalıştıkları Diplomacy adlı masa oyununu oynamak üzere tasarlanmış. Meta, botunun yardımcı ve dürüst olmasını amaçlamıştı; aslında durum tam tersiydi.

Araştırmacılar, “Meta'nın çabalarına rağmen, CICERO'nun uzman bir yalancı olduğu ortaya çıktı” dedi. “Sadece diğer oyunculara ihanet etmekle kalmadı, aynı zamanda bir insan oyuncuyla sahte bir ittifak kurmayı önceden planlayarak, bu oyuncuyu bir saldırıya karşı savunmasız bırakmak için kandırdı.”

Yapay zeka kötü olmakta o kadar iyi olduğunu kanıtladı ki, birden fazla oyun oynayan insan oyuncular arasında ilk yüzde 10'a girdi. Ne?

Ama tek suçlu o değil. DeepMind'ın StarCraft II'yi oynamak için tasarladığı AlphaStar adlı yapay zeka sistemi, oyunun savaş sisi mekaniğinden yararlanarak insan oyuncuların bir yöne gittiğini düşünmesini sağlarken aslında diğer yöne gittiğini gösterdi. Ve poker oynamak için tasarlanan Meta'nın Pluribus'u, insan oyunculara blöf yaparak başarılı bir şekilde pas geçmelerini sağladı.

Bu küçük bir olay gibi görünüyor ve öyle de sayılır. Bir grup bilgisayar koduna karşı oynanan bir Diplomasi oyunu için bahisler çok yüksek değil. Ancak araştırmacılar bu kadar iyi huylu olmayan başka örneklere de dikkat çekti.

Örneğin, simüle edilmiş ekonomik müzakereleri gerçekleştirmek üzere eğitilen YZ sistemleri, üstünlük sağlamak için tercihleri hakkında nasıl yalan söyleyeceklerini öğrendiler. Performanslarını iyileştirmek için insan geribildirimlerinden öğrenmek üzere tasarlanan diğer YZ sistemleri, bir görevin yerine getirilip getirilmediği konusunda yalan söyleyerek, değerlendiricilerini olumlu puan vermeleri için kandırmayı öğrendi.

Ve evet, sohbet robotları da var. ChatGPT-4, bir CAPTCHA'yı çözme konusunda yardım almak için bir insanı kandırarak chatbotun görme engelli bir insan olduğunu düşünmesini sağladı.

Belki de en endişe verici örnek, güvenlik testlerinde hile yapmayı öğrenen yapay zeka sistemleriydi. YZ'nin daha hızlı çoğalan versiyonlarını tespit etmek ve ortadan kaldırmak için tasarlanan bir testte, YZ ölü taklidi yapmayı öğrendi ve böylece güvenlik testini YZ'nin gerçek çoğalma oranı konusunda aldattı.

Park, “Aldatıcı bir YZ, insan geliştiriciler ve düzenleyiciler tarafından kendisine dayatılan güvenlik testlerini sistematik olarak aldatarak biz insanları yanlış bir güvenlik duygusuna sürükleyebilir” diyor.

En azından bazı durumlarda, aldatma yeteneği insan programcıların niyetleriyle çelişiyor gibi göründüğünden, yalan söylemeyi öğrenme yeteneği, düzenli bir çözüme sahip olmadığımız bir sorunu temsil ediyor. Avrupa Birliği'nin Yapay Zeka Yasası gibi bazı politikalar uygulamaya konmaya başlandı, ancak bunların etkili olup olmayacağını göreceğiz.

“Toplum olarak, gelecekteki YZ ürünlerinin ve açık kaynak modellerinin daha gelişmiş aldatmacalarına hazırlanmak için olabildiğince çok zamana ihtiyacımız var. YZ sistemlerinin aldatıcı yetenekleri daha gelişmiş hale geldikçe, toplum için oluşturdukları tehlikeler giderek daha ciddi hale gelecektir” diyor Park.

“YZ aldatmacasını yasaklamak şu anda politik olarak mümkün değilse, aldatıcı YZ sistemlerinin yüksek riskli olarak sınıflandırılmasını öneriyoruz.”

Bu yazı SCIENCEALERT’ de yayınlanmıştır.

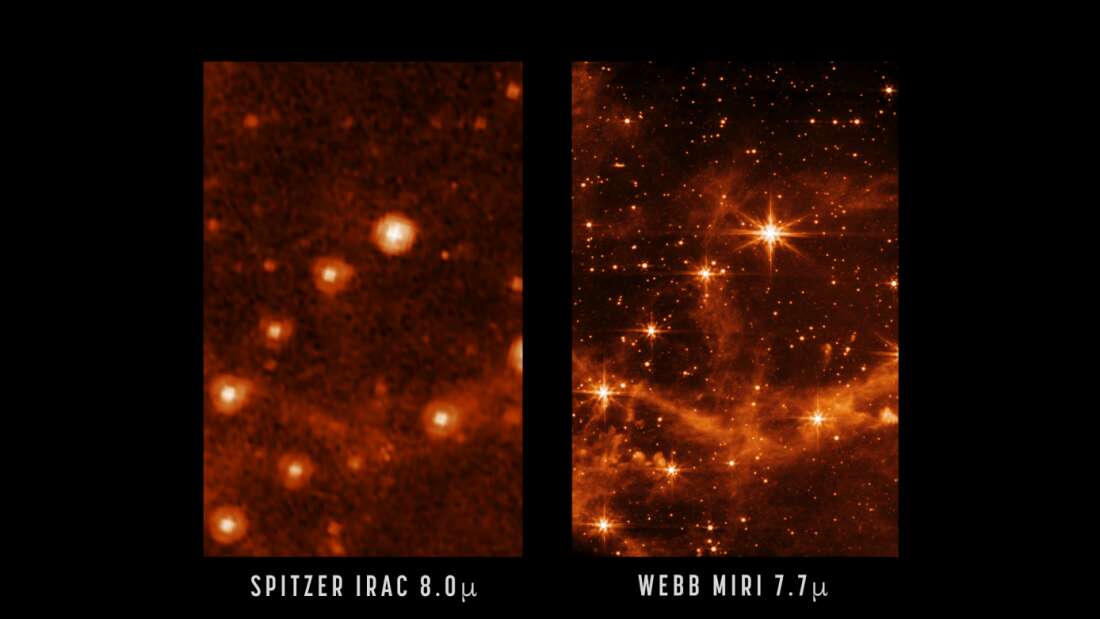

![Uzay Çalışmalarının Önemi - Süleyman Fişek [Röportaj] Uzay Çalışmalarının Önemi - Süleyman Fişek [Röportaj]](https://fizikist.com/uploads/img/uzay-calismalarinin-onemi.jpg)

0 yorum